-

[IT | 기술] 중동의 AI 시장 침공: 역전의 시나리오와 OpenAI의 도전2024.02.24 PM 08:08

하이퍼스케일러 : 구글, 아마존, 마이크로소프트 등 대규모 클라우드 서비스 제공 업체

AI 스타트업 : 오픈AI, 앤트로픽 등

AI 성능 경쟁의 핵심 요소

① 알고리즘 개선

② 인프라 (서버/반도체)

1) 중동을 선택할 수밖에 없는 OpenAI의 속사정

AI 스타트업에 대한 과도한 기대

AI 훈련/추론에는 막대한 비용이 소요

LLM 모델 한 세대만 올라가도 유사 모델의 훈련을 위해 수십 번의 추가 훈련이 필요

게다가 추론 비용은 변동비

→ 이용자가 늘어날수록, 모델이 고도화될수록 증가

AI 시장이 열렸지만, OpenAI는 아직도 추가 펀딩을 받아야 할 정도로 자금 사정이 넉넉하지 않음

반면, 하이퍼 스케일러들은 GPT-4 훈련 비용의 10배 이상을 매년 지출할 수 있음

2) AI 시장을 보는 잘못된 시각

신생기업들이 AI시대의 리더처럼 보이지만 사실은 어려운 상황

① 신생 기업들의 기술력에 대한 착시

초기 펀딩이 필요한 스타트업들은 기술력을 언론에 과시할 필요

반면 하이퍼스케일러들은 경쟁자들에게 자신의 기술을 섣불리 노출할 이유 X

② 패러미터 규모 무용론에 대한 오독

규모의 경제를 먼저 실현하는 것이 AI 패권 경쟁의 핵심

그런데도 하이퍼스케일러들이 규모의 경쟁에 나서지 않는 이유?

초창기 기술의 방향성에 관한 불확실성 때문

기술의 방향이 달라지면 미리 구축해둔 인프라가 매몰 비용이 될 가능성

그래서 하이퍼스케일러들은 막대한 현금을 가지고도 때를 기다리고 있던 것

③ 규모의 경쟁 발발 시점의 오해

이제 OpenAI 같은 퍼스트펭귄들 덕분에 시장 불확실성이 사라지고 있음

특히 MoE같은 신기술로 인해 매몰 비용 리스크 ↓

MoE (Mixture of Experts) : 전문가 혼합 모델

분산 훈련, 합동 추론

특정 주제로 모델을 개별적으로 훈련시킨 후 이 모델들을 한데 묶어 활용

특정 주제로 묶인 데이터들의 연관성 ↑, 개별 훈련 규모 ↓ → 훈련 효율 ↑

하이퍼스케일러들이 걱정하는 매몰 비용에 대한 우려를 덜어줌

기존 방식은 하나라도 잘못되면 모든 것을 잃게 됨

MOE 방식은 훈련시 모델을 쪼갤 수 있고 추론시 모델을 합할 수 있음

그래서 일부가 잘못되더라도 그 부분만 수정 가능

이제 하이퍼스케일러들이 본격적 규모의 경쟁이 본격화될 시기가 오고 있음

OpenAI도 규모의 경쟁에 대비한 펀더멘털을 마련해야 함 (훈련/추론 인프라 구축 등)

장기적으로는 마이크로소프트도 OpenAI의 경쟁자가 될 것

3) 엔비디아보다 더 강력한 무기

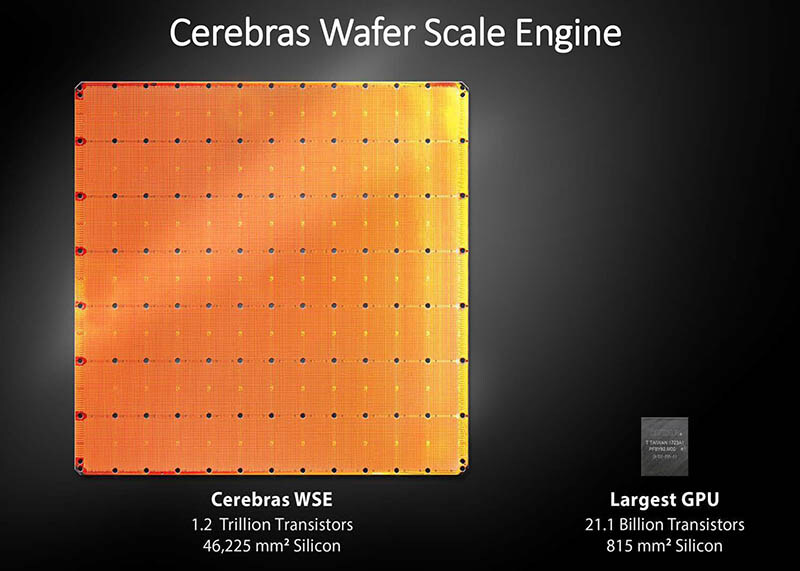

아부다비의 G42와 협력 관계인 AI 반도체 스타트업 '세레브라스 시스템'

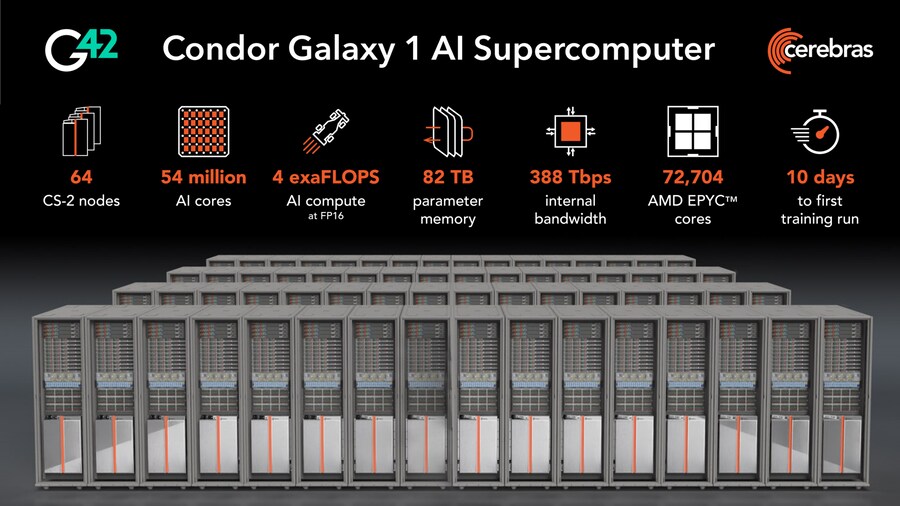

이들이 만든 슈퍼컴퓨터 '콘도르 갤럭시 1' (CG-1)

웨이퍼 스케일 프로세서 탑재

코어 간 대역폭 한계가 없음

단, 대역폭 한계는 없지만 그만큼 빨리 뜨거워지는 문제 발생 (냉각이 관건)

물론 개별 모듈 단에서는 인터커넥트로 연결 (386Tbps)

① 그래서 규모에 따라 선형적으로 성능 증가

② 범용이 아닌 LLM 훈련 전용 솔루션

엔비디아를 포함한 GPU 기반 솔루션은 기존의 게임 그래픽 처리용 GPU를 범용(클라우드, AI 연산 등)으로 개조한 것에 가까움

CG-1이 올해 말에 완성되면 G42와 세레브라스는 세계 최고의 슈퍼컴퓨팅 인프라를 갖추게 됨

샘 올트먼과 아부다비가 협력하면 AI 패권 전쟁에 변수가 될 수 있음

user error : Error. B.