-

[IT | 기술] '챗GPT의 환각에서 벗어나라' AI 최고 석학 얀 르쿤 교수 ‘38쪽 PPT’로 비판2023.04.02 PM 04:47

메타 AI 연구 총 책임자 맡고 있는 얀 르쿤 뉴욕대 교수

최근 세미나에서 챗GPT 기반인 AR-LLM 기술 비판

전문가들 “기술적 한계는 분명하지만, 활용 가능성도 뚜렷”

얀 르쿤 교수

얀 르쿤 미 뉴욕대 교수는 앤드류 응 스탠퍼드대 교수, 요수아 벤지오 몬트리올대 교수, 제프리 힌튼 토론토대 교수와 함께 이른바 ‘인공지능(AI) 4대 천왕’으로 불리는 세계적인 석학이다. 컴퓨터 과학 분야에서 최고의 업적을 남긴 사람에게 주는 튜링상을 받기도 했다. 지금은 미국 IT기업 메타의 AI 연구를 이끌고 있다.

르쿤 교수는 대화형AI 챗GPT의 등장으로 세계적인 열풍에 휩싸인 대형언어모델(LLM) 분야의 선구자 중 한 사람이기도 하다. 하지만 이런 르쿤 교수가 최근 챗GPT 같은 LLM에 대해 강도 높은 비판을 하면서 화제가 됐다.

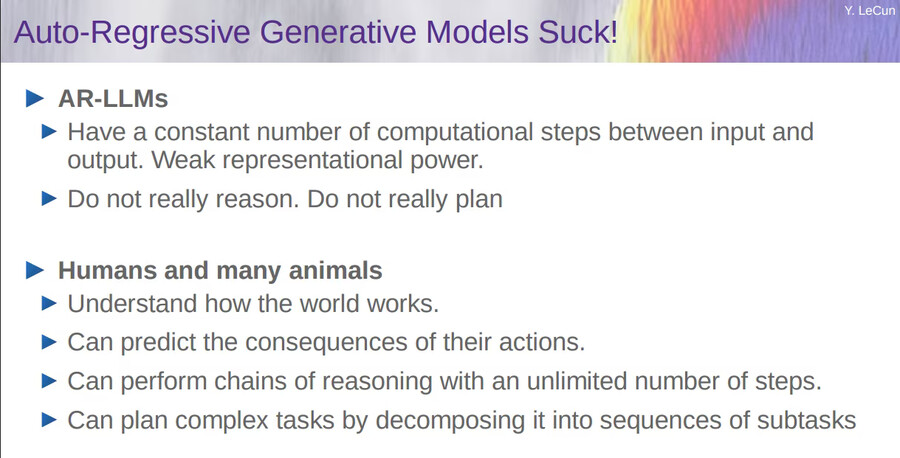

과학계에 따르면 르쿤 교수는 지난 24일(현지 시각) 뉴욕대에서 열린 한 세미나에서 챗GPT 같은 LLM의 한계가 명확하다고 비판했다. 보다 정확히 말하면 르쿤 교수는 ‘Auto-Regressive Generative Models Suck!(자동회귀 생성 모델은 형편없어!)’라는 표현을 썼다.

자동회귀 언어모델(AR-LLM)은 하나의 단어가 주어졌을 때 이전 시점의 데이터를 기반으로 다음에 올 단어를 자동으로 예측하는 언어모델을 말한다. 문제는 AR-LLM은 오로지 통계를 기반으로 단어를 나열한다는 점이다.

최근 챗GPT 관련 기사에 심심치 않게 등장하는 ‘할루시네이션(hallucination·환각)’을 생각하면 된다. 챗GPT가 자신이 잘 모르는 문제에도 그럴 듯한 대답을 내놓거나 오답을 이야기하고도 마치 정답인 것처럼 구는 모습을 어렵지 않게 볼 수 있다. 이런 문제를 기술적으로 표현한 게 바로 할루시네이션이다.

얀 르쿤 교수의 PPT 중 한 페이지. AR 언어모델에 대해 형편없다(Suck)는 표현을 써가며 비판하고 있다. /얀 르쿤 ppt

챗GPT가 자동회귀(AR) 방식을 택했기 때문에 나타나는 문제다. 챗GPT를 개발한 오픈AI는 이런 한계를 보완하기 위해 언어모델의 학습과정에 인위적으로 개입한 인스트럭트GPT(InstructGPT)를 만들었지만, 이것 역시 한계는 분명하다. AR을 통해 학습된 데이터를 후보정하는 것만으로는 AI의 할루시네이션을 근본적으로 제거하는 건 불가능하기 때문이다.

형편없다(Suck)는 표현까지 써가며 르쿤 교수가 챗GPT를 비판한 건 이런 맥락에서다. 르쿤 교수가 발표에 쓴 38페이지짜리 PPT를 보면 보다 자세하게 알 수 있다. 이 PPT에서 르쿤 교수는 공식 하나를 제시한다. ‘P(correct) = (1 - e)^n’라는 단순한 공식이다. 간단하게 설명하면 이 공식은 챗GPT에서 활용되는 토큰의 개수(n)가 늘어날 수록 해당 문장이 사실일 확률(P)이 줄어든다는 뜻이다. 아무리 인위적인 개입을 통해 오류를 줄인다고 할지라도 한 번 발생하는 오류는 계속해서 쌓일 수밖에 없고, 언어모델의 규모가 클수록 이렇게 쌓이는 오류도 커지기 때문에 오류로 인해 AR-LLM이 정답을 이야기할 확률도 기하급수적으로 감소한다는 것이다.

박용범 단국대 소프트웨어학과 교수는 “르쿤 교수의 비판은 이론적으로는 맞는 이야기”라며 “챗GPT를 부정적으로 볼 필요는 없지만, 이런 경고를 무시해서는 안 된다”고 말했다. 김수현 한국과학기술연구원(KIST) 인공지능연구단 책임연구원도 “르쿤 교수의 지적은 AR-LLM이 가진 근본적인 한계에 대한 것”이라고 설명했다.

그렇다면 챗GPT 대신 르쿤 교수가 제시하는 해법은 뭘까. 르쿤 교수는 같은 PPT에서 인간의 뇌 구조를 제시했다. AI나 LLM이 근본적으로 나아가야 할 길은 통계에 기반한 AR-LLM이 아니라 인간의 뇌 구조 자체를 모방해야 한다는 뜻이다. 르쿤 교수는 과거에도 챗GPT에 대해 ‘인간 지능 수준으로 AI가 나아가는 고속도로에서 갓길로 빠져나온 수준의 기술’이라고 혹평을 하기도 했다.

다만 르쿤 교수가 제시하는 인간의 뇌 구조를 닮은 AI는 아직까지 가야 할 길이 멀다. 전문가들도 르쿤 교수의 비판은 이론적인 수준에서 경청할 필요는 있지만, 그 이상도 그 이하도 아니라는 평가를 내린다.

서울대 AI연구원장을 맡고 있는 장병탁 서울대 컴퓨터공학부 교수는 “AR-LLM의 단점도 분명하지만 보완을 해나가면서 다른 모델을 만들 수 있다”며 “르쿤 교수는 메타에 몸을 담고 있기 때문에 오픈AI나 마이크로소프트에 대해 비판적으로 볼 여지가 있는 만큼 이런 부분을 감안해야 한다”고 말했다.

박용범 교수도 “챗GPT에 대해 이론적인 한계가 있다는 비판은 할 수 있겠지만, 이미 챗GPT는 상업적인 영역으로 넘어간 기술”이라며 “기술이라는 건 완벽한 게 아니기 때문에 지금 나와 있는 기술로 무엇을 할 수 있는지를 봐야 하는데 챗GPT는 그런 측면에서 사람들에게 굉장히 좋은 도구가 된 것”이라고 말했다.

김수현 책임연구원도 “르쿤 교수가 AR-LLM의 한계를 언급하면서 제시한 공식도 완전무결한 게 아니다”라며 “우리가 문장을 이야기할 때 단어 한두 개가 틀린다고 뜻이 전달되지 않는 것은 아니듯이 오류가 생긴다고 LLM 자체가 잘못됐다고 볼 필요는 없는 것”이라고 말했다.

user error : Error. B.