-

[IT | 기술] PC 설치형 생성형 AI 모델 ‘딸깍’ 몇 번으로 만나기 [권용만의 긱랩]2024.10.06 PM 03:05

클라우드로 접했던 ‘거대언어모델’ PC에서도 편리하게 쓸 수 있어

엔비디아·인텔, 자사 GPU 최적화 환경 탑재한 ‘앱’ 선보여

서드파티 솔루션 지원은 엔비디아 강세에 인텔 분전, AMD는 아쉬워

‘인공지능(AI)’은 오늘날 IT 영역을 넘어 사회 전반에서 큰 변화를 가져올 핵심 주제로 꼽힌다. 특히 ‘생성형 AI’ 기술은 이미 기업용 IT 업계 구도 전반을 크게 바꾸고 있다. 거대언어모델(LLM)의 운영 능력은 기업과 국가의 경쟁력으로도 해석되고 있다. 다른 한편에서는 ‘AI PC’로의 변화가 두드러지는데 우리가 매일 사용하던 PC에서 AI 관련 기능과 성능을 강화해 일상 속에서 AI를 통해 편의성과 생산성을 높일 수 있게 하는 게 핵심이다.

AI PC 시대로의 변화는 ‘클라우드’에서 사용하던 AI 모델들을 PC에서도 사용할 수 있는 ‘온디바이스 AI’ 시대로의 변화기도 하다.

마이크로소프트는 ‘코파일럿+ PC’ 요건을 갖춘 PC에서 ‘윈도11 24H2’ 업데이트를 통해 클라우드 연결 없이도 이미지 생성 모델이나 실시간 번역 기능 등의 AI 기반 기능을 제공한다는 계획이다. ‘온디바이스 AI’는 클라우드에 연결된 서비스에 비해 인터넷 연결에 대한 부담이 없고 보안에서 유리한 특징을 가진다.

물론 꼭 이런 변화를 기다리기만 할 필요는 없다. 이미 잘 알려진 ‘라마 3(Llama 3)’나 ‘미스트랄(Mistral)’, ‘파이-3(Phi-3)’ 등의 LLM, ‘스테이블 디퓨전(Stable Diffusion)’ 등의 이미지 생성 AI를 PC 수준에서도 충분히 써볼 수 있다. 특히 예전보다 설치와 사용 방법도 많이 쉬워져서 이제는 마우스 클릭 ‘딸깍’ 몇 번이면 바로 쓸 수 있는 앱들도 등장했다. 이들 모델을 돌리는 데 데이터센터급 그래픽처리장치(GPU)가 필요한 것만도 아니다.

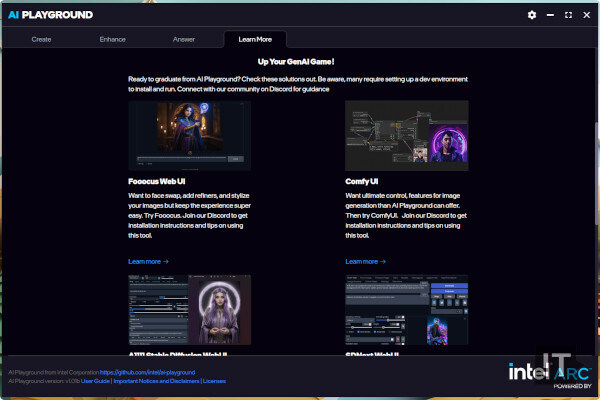

인텔이 선보인 종합 AI 툴세트 ‘AI 플레이그라운드’ / 권용만 기자

가장 쉬운 방법, GPU 제조사들이 내놓는 전용 프로그램

AI 시대 하드웨어 제조사들의 과제는 ‘소프트웨어 지원’이었다. 엔비디아는 지금도 이 부분에서 우위를 보여주고 있다. 하지만 이 우위가 일반적인 인식처럼 ‘쿠다(CUDA)’ 때문인 것은 아니다. 이제 거의 모든 개발자는 ‘쿠다’를 써서 하위 레벨에서부터 쌓아올리기보다는 이미 잘 만들어진 프레임워크와 모델 위에서 개발을 시작하는 상황이다. GPU 개발사들 또한 최신 프레임워크와 라이브러리, 모델에 대한 최적화가 최우선 과제가 됐다.

이러한 관점에서 봤을 때 GPU 제조사들이 내놓는 툴들은 가장 편리하게 최적화된 AI 모델을 사용할 수 있는 방법이기도 하다. 엔비디아의 경우 이미 지난 2월 ‘Chat with RTX’ 앱을 선보였다. 이는 LLM 모델을 PC에서 돌리기 위해 필요한 복잡한 과정을 최대한 단순화하고, ‘마우스 클릭 몇 번으로 지포스 RTX 그래픽카드에서 LLM을 사용할 수 있게 한다. ‘Chat with RTX’의 경우 등장 초기 ‘라마 2’ 모델과 ‘미스트랄 7B’ 모델을 제공했다. 개인 데이터를 학습시키는 ‘검색증강생성(RAG)’도 가능하다.

인텔 또한 비슷한 앱을 선보였다. 인텔이 지난 7월 선보인 ‘AI 플레이그라운드(AI Playground)’는 인텔의 하드웨어에 최적화된 AI 모델과 라이브러리 등을 복잡한 설치과정 없이 클릭 몇 번으로 설치 및 활용할 수 있다. 인텔의 ‘아크’ 외장 GPU나 ‘코어 울트라’ CPU를 지원하는 패키지가 제공된다. 챗봇과 이미지 생성, 이미지 업스케일링 기능이 제공되며 챗봇에는 마이크로소프트의 ‘파이 3 미니’ 모델을, 이미지 생성에는 ‘드림쉐이퍼(Dreamshaper)’ 모델을 사용하는 것이 특징이다.

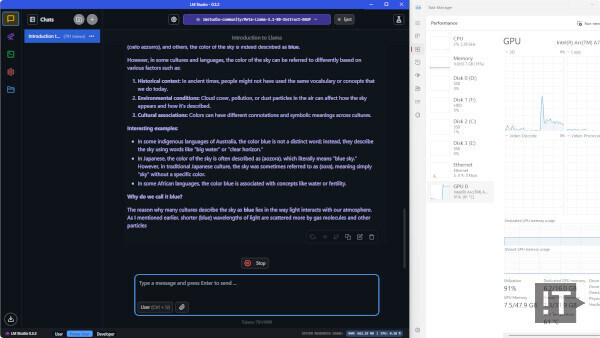

LM 스튜디오로 ‘라마 3.1 8B’ 모델 사용 장면 / 권용만 기자

서드파티 툴들로 다른 모델들도 써보기

처음 LLM이 등장했을 때부터 이를 PC나 워크스테이션 수준에서 돌리기 위한 많은 시도가 있었다. 이제는 이런 시도들이 어느 정도 성과가 나오고 있다. 먼저, LLM을 위해서는 이미 몇 가지의 좋은 도구들이 나왔고 ‘라마 3’ 계열 등 최신 모델까지도 지원하고 있다. 이미지 생성 모델 구동에서는 ‘스테이블 디퓨전’을 위한 ‘AUTOMATIC1111’ 스크립트 등이 대표적인데 실제 설치해 보면 그리 어렵지만은 않다.

‘LM 스튜디오’는 ‘라마 3.1’이나 ‘파이 3’, ‘젬마(Gemma)’, ‘미스트랄(Mistral)’ 등 최신 LLM 모델을 가장 편리하게 사용할 수 있는 방법이다. 프로그램을 설치한 뒤 실행하고 사용하고자 하는 모델을 프로그램 안에서 다운로드 받아서 설치, 실행하면 된다. CPU 뿐만 아니라 엔비디아나 AMD, 인텔의 GPU도 사용할 수 있다. AMD나 인텔의 GPU는 지원이 상대적으로 불안정하다. 한편, GPT4ALL 이나 ollama 같은 툴도 ‘라마’ 계열 LLM 모델을 위한 대안이 될 수 있다.

이미지 생성에서 가장 추천할 만한 도구는 스테이블 디퓨전의 웹 UI를 제공하는 ‘AUTOMATIC1111’ 스크립트다. 이 도구는 설치가 조금 까다로워 보이지만 설명서를 차근차근 따라하면 그리 어렵지만은 않다. 기본이 ‘파이썬’으로 만들어져 있어 시작하기 전에 파이썬 실행 환경이 설치돼 있어야 하고 깃허브에서 데이터를 편리하게 받기 위해 ‘git’를 설치해야 한다. 이후 모델 데이터를 적절한 위치에 넣고 설치한 뒤 실행하고, 웹 브라우저로 사용하면 된다. 한편, 설치 경로에 영문 이외의 문자가 들어가면 문제가 생길 수 있다.

LLM 모델을 사용할 때 개인 PC 수준에서는 CPU만 사용해도 어느 정도는 납득할 만한 결과를 얻을 수도 있다. LLM 사용 시 대략 ‘참을 만한’ 수준으로 평가되는 성능이 초당 10토큰 정도인데 코어 i9-13900KS를 사용한 시스템에서 16쓰레드 설정 사용시 ‘라마 3’에서 초당 15토큰 정도를 처리할 수 있었다. 물론 GPU를 사용하면 이보다 몇 배 더 빠르지만 GPU 활용이 여의치 않은 경우에도 꼭 포기할 필요는 없다. 이미지 생성에서는 GPU나 NPU의 도움을 받는 쪽이 훨씬 유리하고 프로세서 내장 GPU와 NPU로도 의미 있는 성능이 나온다.

AI 활용을 위한 PC 구성 조건에서 당장의 과제는 ‘GPU 메모리’다. / 권용만 기자

AI 활용을 위한 PC 구성 조건, 핵심은 ‘GPU 메모리’

AI 기술의 가능성이 주목받으면서 ‘채굴 시대’ 이후 다시금 GPU 공급 부족이 오지 않을까 하는 우려도 있었다. 하지만, 현재까지 그런 조짐은 크게 보이지 않는다. 이는 데이터센터에서의 대규모 워크로드를 위한 GPU의 기술적 요건과 개인 PC용 GPU의 기술적 특징이 상이하기 때문이기도 하다. 하지만 PC나 워크스테이션 정도를 위해 나오는 AI 모델들도 이제 기술의 발전으로 작은 크기에서도 제법 성능이 많이 올라온 모습을 보인다.

데스크톱 PC에서 최신 AI 모델을 사용하고자 할 때 사양은 높을수록 좋지만 관건은 ‘메모리’다. LLM 모델을 CPU에 올릴 때는 CPU의 코어 수와 메모리 용량이 많을 수록 좋다. GPU에 올릴 때는 최소한 메모리 8기가바이트(GB) 이상의 모델을 선택하는 것이 좋다. 현재 시점에서 순수하게 ‘AI’만을 생각한다면 매력적인 모델은 엔비디아의 ‘지포스 RTX 4060 Ti 16GB’나, AMD의 ‘라데온 RX 7800 XT 16GB’, 혹은 인텔의 ‘아크 A770 16GB’ 정도를 꼽을 만하다.

물론 현실적으로는 이 중에서도 엔비디아의 ‘지포스 RTX 4060 Ti 16GB’나, 아예 예산을 크게 높여서 16GB 메모리를 갖춘 ‘지포스 RTX 4070 Ti 슈퍼’를 사는 게 낫다. 이유는 역시 소프트웨어 지원 문제 때문이다. 인텔의 경우 꽤 지원이 적극적이지만 아직 격차가 있고, AMD는 지원 자체가 그리 적극적이지 않다. AMD의 ‘ROCm’은 최근 지원이 늘고 있긴 하지만 당장 직전 세대인 ‘RDNA2’도 제품군 상당수가 제대로 지원받지 못하고 있다. 그 이전 세대는 아예 지원이 없는 등의 지원 미비 문제가 발목을 잡는다.

노트북 PC에서도 AI를 위한 호환성 측면에서 가장 추천할 만한 조합은 인텔 ‘코어 울트라’ CPU와 엔비디아 ‘지포스 RTX 40 시리즈’ GPU의 조합이다. 인텔의 경우 ‘코어 울트라’의 NPU 활용을 위한 라이브러리 최적화에도 적극적으로 나서고 있고, NPU를 활용한 이미지나 음악 생성 등의 기능을 실제 제공하고 있기도 하다. 반면 AMD의 경우 상대적으로 NPU 지원 폭이 적은 면이 다소 아쉽다.

user error : Error. B.