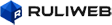

6년 만에 새책 ‘넥서스’ 출간하고

한국 기자단과 화상 간담회 열어

‘주체성’ 가진 인공지능 위험 경고

인공지능 국제기구 필요성도 언급

유발 하라리 히브리대 교수가 15일 오후 5시(한국 시각) 독일 베를린에 있는 베텔스만 랜덤하우스 출판사 사무실에서 온라인 화상 프로그램을 통해 한국 기자단과 인터뷰를 진행하고 있다. 김영사 제공

“인공지능은 삶의 속도, 변화를 가속화한다. 그런데 생명체의 주기를 따르는 사람이 늘 켜져 있는 컴퓨터의 속도에 맞추자면 결국 무너지게 된다.”

‘사피엔스’의 저자 유발 하라리 히브리대 교수(역사학)가 6년 만에 새책 ‘넥서스’(연결)를 출간하고 15일 온라인 화상 프로그램을 통해 기자간담회를 열었다. 정보의 역사와 속성에 관해 다루는 ‘넥서스’는 인공지능이 다른 기술과 달리 주체성과 독립성을 갖춘 ‘행위자’이기 때문에, 인류에게 전에 없던 문제를 가져올 것이라는 점을 하라리 특유의 거시적 안목에서 조망한 책이다. 기자단과의 문답이다.

―인공지능이 딥페이크와 일자리 대체 등 사회문제를 불러일으키고, 불평등과 차별을 강화한다는 견해가 있다.

“인공지능의 기여와 별개로 모든 데이터는 편향에 물들어 있다. 하지만 노력하기에 따라서 편향에서 벗어나게 하는 게 불가능하지 않다. 인공지능의 불평등에서 산업혁명 초기처럼 소수의 국가가 나머지 나라들을 침탈하고 지배하는 문제가 있다. 그 격차를 다른 나라들이 따라잡는데 100년 이상 걸렸는데 인공지능 관련해서도 같은 현상이 생길 수 있다.”

―당신은 ‘넥서스’에서 실리콘 장막이 인간을 새로운 지배자 인공지능과 분리할 수 있다고 했는데, 현실에선 거대기술을 장악한 집단과 나머지 인간을 구분하지 않나?

“인공지능 혁명 초기엔 기술을 이해하고 개발하는 소수가 부와 권력을 갖고 나머지에 장막을 칠 수 있다. 그런데 기술이 성숙하면 부와 권력을 지닌 집단도 인공지능을 통제하지 못할 수 있다. 독재자들도 처음에는 인공지능을 이용해 국민을 더 잘 통제할 수 있다고 여기지만 인공지능이 오히려 독재자를 통해서 국가와 국민을 통제하는 상황이 올 수 있다. 역사상 모든 독재자의 위험은 자신들의 부하들로부터 생겨났다. 인공지능의 잠재적 위협에 더 취약한 것은 남한 같은 민주국가보다 북한 같은 독재국가다.”

―갈수록 복잡도와 자유도가 높아져 가는데 인류가 인공지능을 통제할 수 있는가?

“우리가 직면한 핵심 도전이다. 지금 우리는 국제 사회의 분열에 직면해 있다. 인류가 협력해서 기술을 절제하고 통제적으로 이용한다면 인공지능을 긍정적으로 만드는 게 가능하다. 그런데 국제적 긴장 높아지고 전쟁한다면 어렵다. 당면한 문제는 인류의 내부 분열을 어떻게 극복할 것인가이다. 이런 상황에서 인공지능이 인류를 통제한다면 막을 수 없다.”

―기후위기나 인공지능 규제 등 국제적 협력이 시급한가?

“무조건 규제에 나서기 전에 필요한 단계가 있다. 관찰과 이해다. 현재는 미국과 중국 정도를 제외하고는 어떠한 국가, 기업, 개인도 인공지능 혁명의 의미를 제대로 이해하지 못하고 있다. 극소수 국가와 기업만 이해하고 있는 현 상황에서 필요한 것은 인공지능을 제대로 관찰해 객관적 평가를 내리고 관련 지식을 제공할 수 있는 국제기구다. 그런 뒤에야 비로소 규제를 말할 수 있다. 그렇지만 당장 실행할 수 있는 규제도 있다. 하나는 알고리즘을 실행하는 회사가 결과에 대해 법적 책임을 지게 하는 것이다. 또 하나는 인공지능이 사람인 척하고 상호작용하지 못하게 하는 것이다.”

― 개인들은 인공지능 거대 담론보다 자신의 일자리의 미래가 불안한데?

“ 인공지능은 삶의 속도 , 변화를 점점 가속화하고 있다. 사람 누구나 불안과 강박을 느끼고 있다 . 인간의 생물학적 , 유기체적 속도와 비유기체인 컴퓨터의 속도 간 긴장이다. 유기체의 삶은 운동과 휴식, 잠 등 주기에 따르지만 , 컴퓨터는 항상 켜져 있다. 인공지능이 점점 더 많은 영역에 통합되며 사회를 잠식함에 따라 우리도 기계의 속도에 맞추기를 강요당하고 있다. 이는 불안함을 넘어 위험하다 . 유기체인 인간이 기계처럼 항상 켜져 있으면 결국 무너진다.”

―미래 세대에겐 어떤 역량과 지식을 교육해야 하는가?

“20년 뒤의 직업시장이 어떨지, 어떤 기술이 유용할지 말할 수 있는 사람 아무도 없다. 어떤 기술을 가르칠지 좁게 정의하면 모든 게 물거품이 될 수 있다. 손과 두뇌, 머리와 가슴, 신체적 능력을 골고루 균형 잡히게 갖추는 사람이 미래엔 전문적 능력 갖춘 사람보다 더 중요한 일을 할 것이다. 무엇보다 정신적 유연성이 중요하다. 인공지능이 사회를 점점 더 빨리 바꾸고 새로운 직업과 기술이 등장하는 상황에서는 평생에 걸쳐 새롭게 배우고 바꾸는 일을 반복하게 된다. 이를 위해선 정신적 유연성이 필요하다. 계속 새로 배우고 끊임없이 변해갈 수 있는 능력을 손에 쥐여줘야 한다.”

―이스라엘-팔레스타인 전쟁에서 인공지능 기술 사용되고 있는데 어떻게 보나?

“이미 인공지능이 전쟁 양상을 바꾸고 있다. 킬러 로봇 없이도 인공지능은 다른 모습으로 전쟁에 적극적으로 참여하고 있다. 엄청나게 방대한 정보를 분석해 목표물을 인공지능이 정해 타격한다. 인공지능이 올바른 목표물을 설정했는지, 국제법을 준수했는지 등을 확인하기 어려운 문제가 있다. 그런데 이 전쟁에서 인공지능이 사용되고 있지만, 전쟁은 인간의 믿음과 신화 때문에 초래된 것이다. 객관적 현실을 보면, 이스라엘과 팔레스타인 지역에 자원이 부족하진 않다. 땅, 에너지, 식량이 그 지역 사람들 살기에 충분하다. 문제는 신이 자신들에게만 허락한 곳이라는 믿음 때문에 전쟁이 벌어진 것이다. 인공지능이 사람을 죽이고 있지만, 인간이 상상으로 만든 수천 년 전 신화에 대한 믿음 때문에 전쟁이 초래된 것이다.”

하라리는 많은 민주국가에서 공론장의 위기 원인으로 알고리즘과 챗봇이 사람들의 대화에 끼어들어 가짜 정보와 음모론을 퍼뜨리는 상황을 지적했다. 대화의 상대가 사람인지, 봇인지를 모르면 민주주의 유지가 어렵기 때문에 봇을 구분하는 문제가 중요하다고 말했다. 하라리는 “하루 2시간씩 명상하고, 일년에 1~2개월 외부와 완전히 단절하고 침잠하는 시간을 갖는다”며 “정신에 있어 정보는 음식과 같아 너무 많으면 해롭고, 소화하는 시간인 성찰과 숙고가 필요하다”고 말했다.